Преоткритата мания по изкуствения интелект и рисковете от нея

Темата за изкуствения интелект (ИИ) добива изключително обществено внимание през последните месеци - от бомбастичното появяване на ChatGPT на сцената до все по-бързо набиращите популярност платформи за генеративен ИИ Faceswap и Midjourney. Възхищение, но и въпроси и критика изпълват коментарите относно все по-бързо развиващата се технология. Поразяващата точност и креативност на гореспоменатите платформи за ИИ заляха като вълна първите страници по света. Умението на ChatGPT да пише курсови работи, да решава тестове, да пише поезия, да предава информация и още куп други неща и изключително реалистичните генерирани “дийпфейк“ (deepfake - дълбок фалшификат) изображения на Faceswap и Midjourney хванаха много хора неподготвени.

Събудилата се мания по ИИ се усети веднага: забраниха ChatGPT в Италия, всички технологични гиганти веднага обявиха собствените си проекти за генеративен ИИ, фалшиви снимки на президента на Франция Еманюел Макрон от протестите в страната и дийпфейкове за „ареста“ на бившия президент на САЩ Доналд Тръмп заляха интернет и дори си проправиха път в медиите. Органът на ЕС за защита на личните данни създаде работна група за ChatGPT, която да помогне на държавите за справяне с чатбота, ИИ успя да спечели конкурс по фотография в Германия, Кувейт се сдоби със собствен телевизионен водещ с ИИ, Илон Мъск призова да се спре тестването на ИИ, заради безопасност, докато Бил Гейтс направи точно обратното и се противопостави на предложената забрана - накъдето и да се обърнем, новините за ИИ са навсякъде.

Какво е дийпфейк

Преди да разгледаме примерите за влиянието и потенциалните проблеми на тази технология в отделните сфери на живот, трябва да знаем какво точно е дийпфейк.

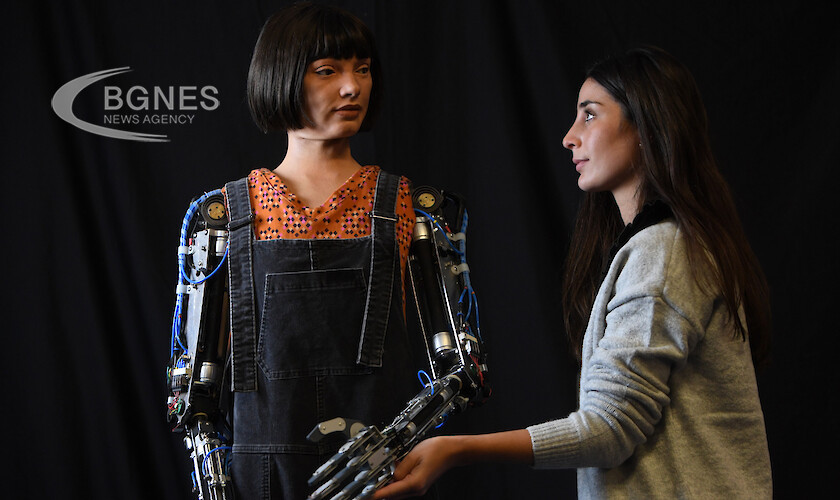

Дълбоките фалшификати използват изкуствен интелект за генериране на напълно нов видеоклип или аудиоклип, като крайната цел е да се представи нещо, което всъщност не се е случило в действителност.

Терминът "deepfake" идва от основната технология - алгоритмите за дълбоко обучение, които се научават да решават проблеми с големи набори от данни и могат да се използват за създаване на фалшиво съдържание на реални хора.

"Дийпфейк би бил кадър, генериран от компютър, който е обучен чрез безброй съществуващи изображения", казва пред „Бизнес инсайдър“ Кристина Лопес, старши анализатор в Graphika - фирма, която изследва потока от информация в цифровите мрежи.

Компютърно подпомагани технологии като Photoshop и CGI често се използват за създаване на медийни продукти, но разликата е, че във всяка стъпка от процеса участват хора. При тези генерирани от ИИ не се изисква особено умение от страна на човека, за да се създаде каквото и да е, ИИ върши всичко.

Съществуват няколко метода за създаване на дийпфейк, но най-разпространеният се основава на използването на дълбоки невронни мрежи, които използват техника за подмяна на лица. Първо се нуждаете от целеви видеоклип, който да използвате като основа на дълбокия фалшификат, след това и от колекция от видеоклипове на лицето, което искате да вмъкнете в целевия видеоклип.

Видеоклиповете могат да бъдат напълно несвързани: целта може да бъде например клип от холивудски филм, а видеоклиповете на лицето, което искате да вмъкнете във филма, може да бъдат произволни клипове, изтеглени от YouTube.

Програмата отгатва как изглежда лицето от различни ъгли и условия, след което съпоставя това лице с другото от целевия видеоклип, като намира общи характеристики.

Към микса се добавя друг вид машинно обучение, известно като Generative Adversarial Networks (GAN), което открива и подобрява всички недостатъци в дийпфейка в рамките на няколко кръга, като затруднява декодирането им от детектори за дийпфейк.

Въпреки че процесът е сложен, софтуерът е доста достъпен. Има огромен брой приложения, които извършват тази дейност - това не е монопол на изброените в началото на текста генеративни ИИ платформи.

Стара нова мания

Също така е важно да се отбележи, че това не е нещо ново. Първите случаи на популярни дийпфейк „новини“ се появяват още 2018 г., но, за разлика от тогава, технологията е по-усъвършенствана и успя да пробие изцяло в мейнстрийма.

Подобни открития, които заплашват с влиянието си установени от поколения обществени процеси, не са нещо необичайно. Индустриалната революция напълно промени света, като буквално разрушава вековни структури в обществото, и не малка част от свързаните с нея страхове се повтарят и сега. Потенциалната загуба на работни места, които ще бъдат заменени от ИИ, наподобява същите страхове относно използването на нови машини за производство през XIX век. Също така огромният скок в продуктивността след революцията може да се срещне и при масовото навлизане на ИИ в работния процес, тъй като се вижда, как ИИ изпълнява задачи по-бързо от хората с невинаги по-лош резултат.

Позитивният ефект на индустриалната революция не означава, че трябва да се пренебрегват редицата опасности, които ИИ поставя. Индустриалната революция промени работния процес достатъчно постепенно, така че хилядите занаятчии да могат да се пренасочат и да не останат накуп без работа. По този начин не се реалиира този краен сценарий за хиляди безработни и бедни, станали такива по вина на машините. Поради това трябва да се обърне внимание на някои проблеми, които произтичат от ИИ.

Дийпфейк порно

Разследване на Кат Тенбарж от "Ен Би Си Нюз" показва колко обезпокоително разпространено и достъпно е станало дийпфейк порното без съгласие.

Не е необходимо да търсите в "тъмната мрежа" или да сте особено компютърно грамотни, за да намерите дийпфейк порно. Два от най-големите уебсайтове, които предлагат това съдържание, са леснодостъпни чрез Google. Създателите на сайтовете използват онлайн чат платформата Discord, за да рекламират стоката си, а хората могат да плащат за нея с Visa и Mastercard. Бизнесът процъфтява дотолкова, че "двама популярни създатели предлагат платени позиции, които да им помагат да създават съдържание".

Не е изненадващо, че жените са тези, които в голяма степен са засегнати от възхода на този тип порно. В доклад от 2019 г. на Sensity - компания, която открива и следи дълбоките фалшификати, се установява, че 96% са били сексуални без съгласие, а в 99% от тях са участвали жени. Все по-често жените, към които са насочени, не са само известни личности, както наскоро, например, Скарлет Йохансон и Ема Уотсън бяха използвани в сексуални реклами с помощта на Faceswap, но можете и да получите дийпфейк порно, направено по поръчка с участието на всекиго, който ви харесва. "Създател предложи в Discord да направи петминутен клип на момиче от Instagram, за 65 долара".

По-рано тази година стриймър от Twitch на име Брандън "Атриок" Юинг призна, че е купувал и гледал дийпфейк порно на свои колеги-жени. Признанието дойде само защото без да иска показа прозорец за такова порно на компютъра си по време на стрийм.

Една от жените, за които се твърди, че са станали мишена на дийпфейк порно, стриймърката QTCinderella, разказа за пораженията, които това е нанесло върху психическото ѝ здраве. "Ето как изглежда чувството, че си насилван, ето как изглежда чувството, че си използван", каза тя в предаване на живо на 30 януари. "Ето как изглежда да се видиш гола против волята си, разпространявана из целия интернет", сподели тя. "Не би трябвало да е част от работата ми да плащам пари, за да бъдат свалени тези неща. Не би трябвало да е част от работата ми да бъда тормозена, да виждам как се разпространяват мои "голи" снимки."

Изкуството и ИИ

Последиците от генерирането на изображения с изкуствен интелект са мащабни и могат да повлияят на всичко- от филми до графични романи. Детските илюстратори побързаха да изразят загриженост относно технологията в социалните мрежи. Сред тях е авторът и илюстратор Роб Бидълф, който казва пред „Гардиън“, че изкуството, генерирано от изкуствен интелект, "е точно обратното на това, което вярвам, че е изкуството. В основата си винаги съм смятал, че изкуството се състои в това да предадеш нещо, което чувстваш вътрешно, в нещо, което съществува външно. Каквато и форма да приема, независимо дали става дума за скулптура, музикално произведение, писане, пърформанс или изображение, истинското изкуство е свързано с творческия процес много повече, отколкото с крайното произведение. А простото натискане на бутон за генериране на изображение не е творчески процес."

Освен творчеството има и по-задълбочени въпроси. В онлайн кампания - #NotoAIArt - художници споделят опасения относно законността на генераторите на изображения с изкуствен интелект и за това как те имат потенциала да обезценят уменията за рисуване на илюстрации. За да създават изображения от подсказки, ИИ генераторите разчитат на бази данни с вече съществуващи произведения на изкуството и текст. Те се състоят от милиарди изображения, които са били извлечени от интернет. Сред най-големите е наборът от данни с отворен код LAION-5B, използван от Text 2 Dream на DDG. Калоян Чернев, основател на DDG, казва, че наборът от данни се състои "до голяма степен от изображения, които са обществено достояние и са получени от интернет", но много художници и илюстратори казват, че базите данни често включват и много изображения, защитени с авторски права.

Дийпфейк и изборите в САЩ 2024 г.

Предизвикателство за медиите през 2024 г. със сигурност ще бъде начинът, по който се справят с изкуствения интелект. С новите успехи в технологиите ИИ буди голяма тревога заради използването му в социалните мрежи и приноса му за дезинформацията - той се развива бързо и лесно се превръща в убедителен аудиоматериал, изображение или текст. Неотдавнашен пример са фалшивите изображения, генерирани от ИИ, на които бившият президент Доналд Тръмп е арестуван, и които бързо се разпространиха в социалните мрежи.

Експерти споделят пред "Уошингтън Поуст", че усъвършенстването и достъпността на ИИ значително изпреварват регулаторните и законодателните реакции, както и корпоративния контрол, и представляват огромен риск за изборния цикъл през 2024 г.

Аудио дийпфейк измами

Опасностите не са ограничени до текст и изображения- аудио дийпфейк е изключително популярен. Лесно може да се открият най-различни аудио материали в интернет с дийпфейк съдържание. Може да се натъкнете лесно на разговор между бивши американски президенти, които, докато играят „Minecraft” и събират минерали, си говорят открито за военни престъпления и контрол над оръжията. Ако американската политика не ви трогва, то как Ема Уотсън чете „Моята борба“ на Адолф Хитлер може да ви заинтригува повече. Комедийният успех на тези дийпфейкове е поразителен, но също така и показва колко лесно и достъпно е. Подобно нещо може да бъде използвано за къде по-подли цели от това да се правят иронични клипчета в YouTube.

Обажда ви се член на семейството, който е в беда и ви иска спешно пари, а вие се съгласявате. Накрая се оказва, че сте били измамени от фалшив глас на роднина, генериран от ИИ. Телефонните измами далеч не са нещо ново, но дори сега хора биват подлъгвани по различни начини, особено по-възрастните. С подобно ново оръжие в арсенала на измамниците не е трудно човек да си представи по-горния пример.

Според експертите по компютърни науки, това не изисква много работа.

"Не им е необходима много голяма част от гласа, за да направят доста добро възпроизвеждане", каза в интервю за Евронюз Матю Райт, ръководител на катедрата по компютърни науки в Технологичния институт в Рочестър.

"Можете да си представите, че те просто се обаждат, преструват се на продавач и улавят достатъчно от гласа, за да върши работа. И това може би е всичко, от което ще се нуждаят, за да заблудят някого", обяснява той.

Неотдавна журналист от Vice успя да проникне в банковата си сметка, като използва ИИ реплика на гласа си. Той накара банката да мисли, че това е той, за да получи достъп до транзакциите си, поставяйки под въпрос системите за сигурност с гласови биометрични данни.

Дезинформация

Поразяващите умения на ChatGPT на OpenAI да пише сложни и креативни текстове, напълно достатъчни за домашна работа на ученик или курсов проект на студент, дават нови хоризонти за потенциална дезинформация.

"Този инструмент ще бъде най-мощното средство за разпространение на дезинформация, каквото някога е имало в интернет", казва пред „Ню Йорк Таймс“ Гордън Кровиц, съизпълнителен директор на NewsGuard - компания, която следи дезинформацията в интернет. "Изготвянето на нов фалшив разказ вече може да се извършва в драматичен мащаб и много по-често - това е все едно да има агенти с изкуствен интелект, които допринасят за дезинформацията."

Дезинформацията е трудна за отстраняване, когато се създава ръчно от хора. Изследователите прогнозират, че генеративната технология може да направи дезинформацията по-евтина и по-лесна за създаване за още по-голям брой конспиратори и разпространители на дезинформация.

Персонализираните чатботове в реално време биха могли да споделят конспиративни теории по все по-достоверни и убедителни начини, казват изследователите, като изглаждат човешките грешки като лош синтаксис и грешни преводи и напредват отвъд лесно откриваемите copy-paste задачи. И казват, че никоя от наличните тактики за смекчаване на въздействието не може да се справи ефективно с това.

Най-добрата защита срещу дезинформацията си остава нивото на медийна грамотност в обществото. В държава като Финландия, която е на първо място по този индекс в Европа, подобни фалшиви кампании биха имали ограничен ефект.

Други рискове, изложени от ЕС

В обновена статия на Европейския парламент от 2018 г. за възможностите и рисковете от ИИ, ЕП отличава още няколко важни риска от новата технология.

Предизвикателство е да се определи кой е отговорен за щети, причинени от устройство или услуга, управлявани от ИИ, при произшествие със самоуправляващ се автомобил. Дали щетите трябва да бъдат покрити от собственика, от производителя на автомобила или от програмиста?

Ако производителят е абсолютно свободен от отговорност, може да няма стимул да предоставя добър продукт или услуга и това да накърни доверието на хората в технологията; но също така регулациите могат да бъдат твърде строги и да задушат иновациите.

ЕП също така посочва риска върху работните места. Очаква се използването на ИИ на работното място да доведе до премахването на голям брой работници. Независимо че ИИ може да създаде и подобри работни места, образованието и обучението ще имат решаваща роля за предотвратяване на дългосрочната безработица и за осигуряване на квалифицирана работна сила.

14% от работните места в страните от ОИСР са с възможност за висока степен на автоматизация, а други 32% биха могли да претърпят значителни промени (оценка на парламентарния мозъчен тръст "Think Tank 2020").

Рискове за журналистиката

Големият брой генеративни ИИ поставя под заплаха и журналистиката: освен потенциалното уголемяване на фалшивите новини и дезинформацията, която трябва да бива филтрирана и проверявана, ИИ може и директно да наруши работата на медиите.

Пример за това е казус на „Гардиън“ с ChatGPT от началото на месеца. Британският вестник получава редица имейли за несъществуващи статии, които уж са били направени от екипа на изданието. След проверка се установява, че ChatGPT буквално е правил статии сам, когато е бил попитан за източници за определена информация. Чатботът разполага с толкова голяма база данни, че без проблем е направил достоверно изглеждаща статия, напълно в стила на вестника.

В писмото, което „Гардиън“ пише по този въпрос, достатъчно красноречиво описва опасностите за медиите.

„Потенциалните заплахи за автентичността на новините, трудностите за журналистите и потребителите при проверката на привидно правдоподобна информация и почти сигурното създаване на убедително, но фалшиво съдържание от недоброжелатели, стават все по-обезпокоителни, колкото повече мислите за тях.

Това е предизвикателство за всички медии. При все по-нарастващата способност за цифрово генериране на аудио и видео, рискът за репутацията на печатната, онлайн и излъчваната журналистика изисква отговор в цялата индустрия. Спешно е издателите и регулаторните органи да се обединят, за да договорят най-добрите практики.“

Отговорът, който самият бот дава на „Гардиън“, когато бива запитан за фалшивите статии също е любопитен.

"Като езиков модел с изкуствен интелект осъзнавам рисковете, свързани с генерирането на фалшиви статии, и потенциалните вреди, които това може да причини. От решаващо значение е обаче да се разбере, че отговорността не е на самата технология, а на тези, които я използват. Езиковите модели с изкуствен интелект като мен могат да бъдат мощен инструмент за създаване на информативно и увлекателно съдържание, но е важно да ги използваме етично и отговорно. Призовавам всички да поемат отговорност за действията си и да използват ИИ езиковите модели за подобряване на обществото."

Като заключение може да се види от споменатите примери огромните възможности на тази технология, но също така и рисковете, които произтичат от нея. Особено важно е тя да бъде въвеждана отговорно и да бъде изпробвана, и е нужно институциите и органите да се адаптират към новата среда. /БГНЕС

-----------------

Георги Василев, редактор в отдел "Международни новини" на Агенция БГНЕС.

София / България